线上感知模块

Apollo 2.0感知模块包括障碍物检测识别和红绿灯检测识别两部分。障碍物检测识别模块通过输入激光雷达点云数据和毫米波雷达数据,输出基于两种传感器的障碍物融合结果,包括障碍物的位置、形状、类别、速度、朝向等信息。红绿灯检测识别模块通过输入两种焦距下的相机图像数据,输出红绿灯的位置、颜色状态等信息。上述两大感知功能,使无人车具备在简单城市道路自动驾驶的能力,希望能够对无人驾驶社区有帮助。如果对算法细节有兴趣,请查阅github上的技术文档。

感知核心模块

障碍物检测识别

障碍物模块包括基于激光雷达点云数据的障碍物检测识别、基于毫米波雷达数据的障碍物检测识别以及基于两种传感器的障碍物结果融合。基于激光雷达点云数据的障碍物检测识别,通过线下训练的卷积神经网络模型,学习点云特征并预测障碍物的相关属性(比如前景物体概率、相对于物体中心的偏移量、物体高度等),并根据这些属性进行障碍物分割。基于毫米波雷达数据的障碍物检测识别,主要用来对毫米波雷达原始数据进行处理而得到障碍物结果。该算法主要进行了ID扩展、噪点去除、检测结果构建以及ROI过滤。多传感器障碍物结果融合算法,用于将上述两种传感器的障碍物结果进行有效融合。该算法主要进行了单传感器结果和融合结果的管理、匹配以及基于卡尔曼滤波的障碍物速度融合。具体算法请参阅github技术文档。

红绿灯检测识别

红绿灯模块根据自身的位置查找地图,可以获得前方红绿灯的坐标位置。通过标定参数,可以将红绿灯从世界坐标系投影到图像坐标系,从而完成相机的自适应选择切换。选定相机后,在投影区域外选取一个较大的感兴趣区域,在其中运行红绿灯检测来获得精确的红绿灯框位置,并根据此红绿灯框的位置进行红绿灯的颜色识别,得到红绿灯当前的状态。得到单帧的红绿灯状态后,通过时序的滤波矫正算法进一步确认红绿灯的最终状态。我们提出的基于CNN的红绿灯的检测和识别算法具有极高的召回率和准确率,可以支持白天和夜晚的红绿灯检测识别。具体算法请参阅github技术文档。

视频介绍

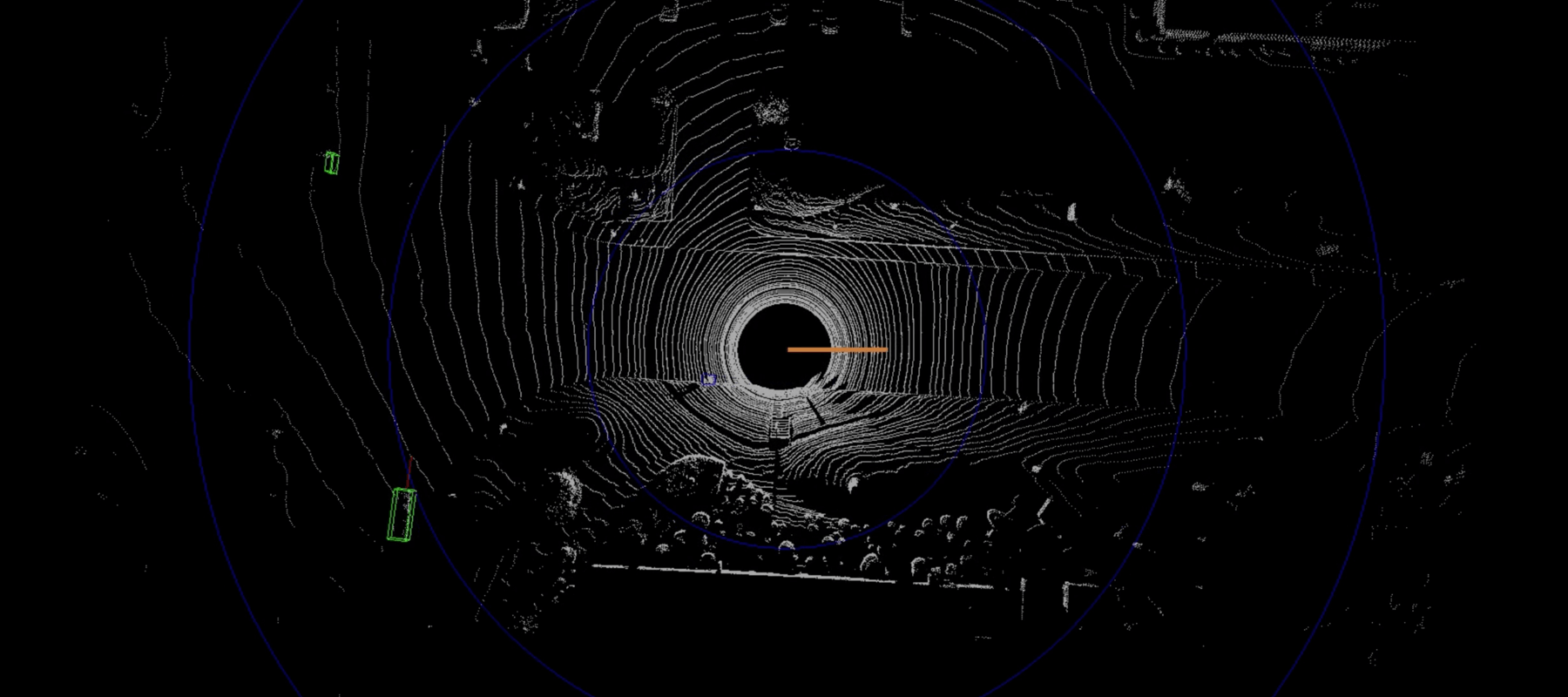

离线可视化工具的感知演示

这里我们用离线可视化工具演示感知障碍物输出结果。该工具能逐帧显示点云以及感知算法输出的障碍物。原始点云用灰色表示。检测到的障碍物,车辆、行人、自行车、未知类别分别用绿色、粉色、蓝色、紫色表示。红色箭头表示朝向。

Dreamview仿真器的感知演示

这里我们用dreamview仿真器来演示感知障碍物输出结果。这是一个接受感知topic输出的工具并且可视化地图和感知结果。障碍物用紫色表示,白色箭头表示朝向。

线下标定平台

Apollo提供云端的跨平台标定服务,使开发者无需在本地或车端配置运行标定程序,大大提升了进行跨平台标定的灵活性,最大程度地为开发者降低开发门槛。

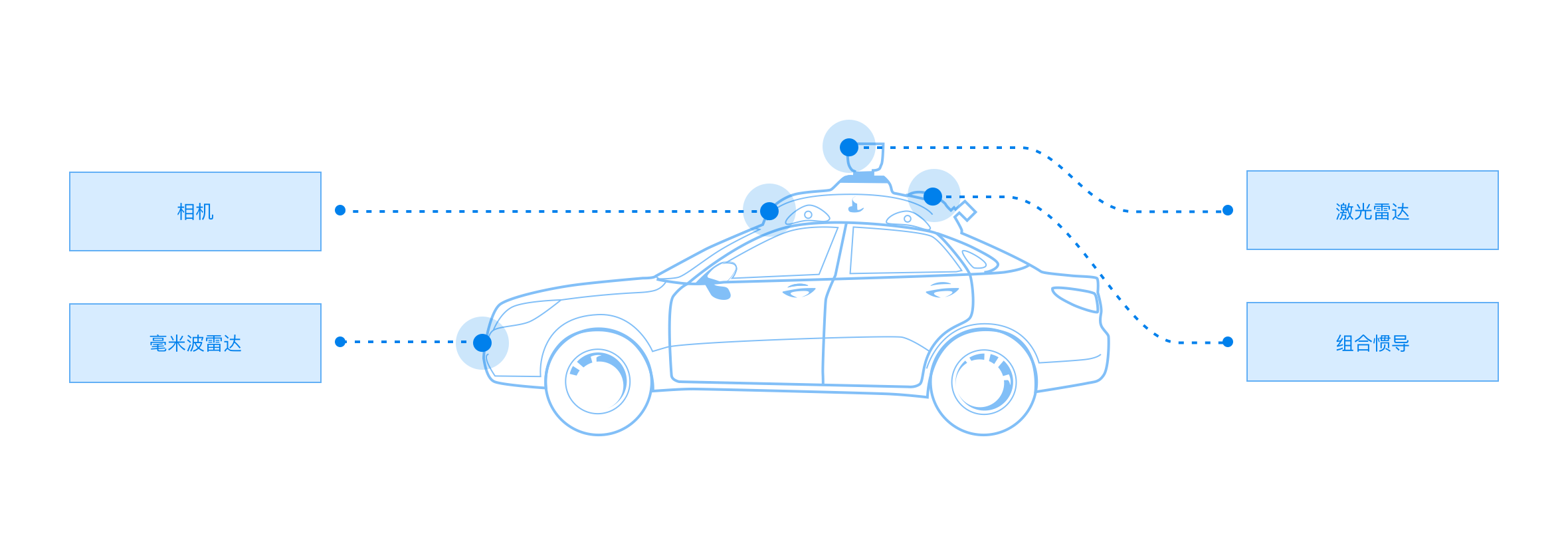

自动驾驶传感器标定(Calibration)是指利用传感器采集的数据计算各传感器的内参数(Intrinsic Parameters)以及多个传感器之间外参数(Extrinsic Parameters)的过程。传感器内外参的标定是各类多传感器信息融合算法的第一步。

在自动驾驶领域中,多线激光雷达与组合惯导是高精地图制作、激光点云定位以及点云物体检测任务中常用的传感器配置。因此精确标定两者之间的外参数具有非常重要的意义。除此以外,自动驾驶系统使用多传感器融合策略来提高感知性能。因此,相机与毫米波雷达的外参标定也至关重要。